요즘 챗GPT 많이 사용하시나요???

저는 개인적으로 공부에 대한 도움을 많이 받고 있어요...

특히나 영어공부 할때... 부동산 공부 할때.. 이럴때 말이에요..

그런데.. 알고 계셨나요??

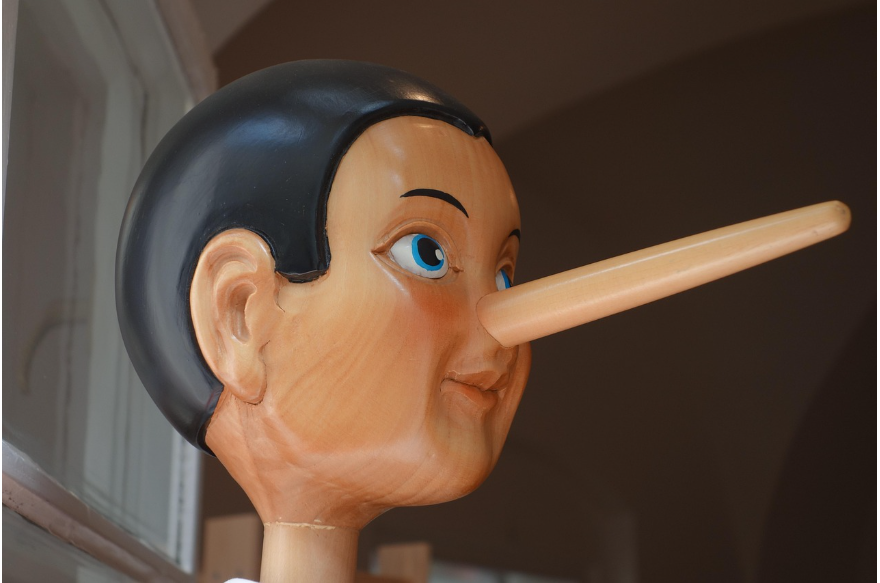

챗지피티 뿐만 아니라 AI가 우리에게 거짓말을 한다는 사실이요...

이런 현상을 바로 "할루시네이션" 이라고 하는데요..

오늘은 이 할루시네이션에 대해 알아보려고 합니다..

할루시네이션이란??

가끔 챗지피티를 사용하다보면...

엄청 똑똑하다는 생각이 많이 드실꺼에요...

그런데 가끔.. "어?? 이거 진짜 맞아??" 이런 말이 툭 튀어 나올때가 있습니다...

심지어 전혀 사실이 아닌데 너무나도 그럴싸하게 설명을 해서..

의심없이 깜빡 속을 때도 있습니다...

이런걸 바로 AI의 할루시네이션이라고 합니다...

이런 현상이 발생하는 이유는요...

AI가 질문에 대한 답을 만들 때 사실을 "기억"해서 말하는게 아니라...

엄청난 양의 데이터를 학습해서 "그럴듯한 말을 이어붙이는 것"이기 때문입니다...

그러다보니 가끔은 근거 없는 내용도 그럴싸하게 지어내는 경우가 있어요...

저는 그걸 거짓말 한다고 표현을 하는거구요...

이런게 바로 할루시네이션이에요~

예를들어 이런 경우가 있습니다..

✅ 실제로는 없는 책 제목을 이야기 하기도 합니다..

질문자 : "챗GPT.. 재테크 책 추천해줘!!!"

AI : "[부자 엄마 가난한 엄마] / [돈 버는 습관 101]"

답변이 그럴싸해 보이지만...

실제로 저런 책들은 없는 책들 입니다..

✅ 없는 서비스 이름을 이야기 하기도 합니다..

질문자 : "스마트스토어 운영 도와주는 프로그램 뭐 있어???"

AI : "네이버 프로매니저 360"

이 역시 실체가 없는 서비스 입니다..

✅ 잘못된 정보를 섞어내기도 합니다..

질문자 : "서울에 있는 세계문화유산 알려줘"

AI : "경복궁, 덕수궁, 한라산"

실제 한라산은 제주도에 있는데 말이죠...

이런 일이 생기는 이유는...

AI가 일부러 질문자를 농락(?) 하기 위해 일부로 거짓말을 하는건 아닙니다...

학습 데이터의 한계와 답을 만드는 방식 때문에 생기는 문제에요~

AI가 답을 만드는 방식은요??

AI가 질문자의 질문에 답변을 하는 몇가지 방식이 있습니다..

✅기억이 아닌 패턴

챗 지피티는 우리가 생각하는 기억을 가지고 있지 않습니다..

대신.. 인터넷에 있던 텍스트, 책, 뉴스, 위치 등... 정말 방대한 양의 데이터를 학습해서...

"어떤 단어 다음에 어떤 단어가 올 확률이 높을까??" 를 예측하는 방식으로 답변을 합니다...

✅ 확률게임...

무슨이야기냐... 예를들어 "서울의 수도는?" 이라는 질문이 오면

"대한민국"이라는 단어가 뒤에 올 확률이 높다고 계산해서 내 놓는것입니다...

이렇게 "단어 단위로 확률을 계산해 가장 자연스럽고 그럴듯한 문장!!!!" 을 만들어 답변을 하는거죠...

✅ 사실 검증은 안함

GPT는 방대한 양의 데이터를 학습하면서..

그 데이터가 진짜인지 거짓인지 실제로 확인을 하지 않습니다...

그냥.. 그럴듯한 말을 생성해 낼 뿐이죠...

그래서 때로는 근거 없는 말도 자신있게 내놓는 것이죠....

이러한 이유들로 AI가 하는 답변에 자연스럽게 거짓말이 들어간다고 볼 수 있습니다..

그럼 AI를 못믿어야 할까요??

꼭 믿어라, 믿지 마라의 이야기는 아닙니다...

실제로 챗GPT는 정말 유용한 도구이고, 저 역시도 유용하게 잘 활용하고 있습니다..

그 뿐만 아니라 검색, 요약, 아이디어 브레인 스토밍, 업무 보조 등 다양한 분야에서 활용되며..

이용하는 사람들의 시간을 절약해주는 역할을 톡톡히 하고 있습니다..

하지만 중요한건...

챗GPT의 말을 무조건 믿기 보다는...

AI가 한 이야기라 할 지라도 한번씩 질문자 스스로가 검증을 할 수 있어야 한다는 것 입니다...

사람도 실수하듯이 AI도 실수 할 수 있으니까요..

그래서 무조건 AI가 하는 말을 곧이 곧대로 받아들이기 보다는

질문자 스스로가 한번쯤 판단하고 최종 판단을 해야 하지 않을까 생각합니다...

그래서 저는 이렇게 프롬프트를 쓰기도 합니다.

저도 가끔 잘못된 답변을 받아 답답했을 때가 한두번이 아닙니다..

하지만.. 이걸 최소화 하고자 저는 이런 프롬프트를 같이 쓰기도 합니다..

이 질문에 답할 때 반드시 근거(출처)를 포함해줘...

근거가 없으면 "잘 모르겠다"고 대답해줘...

잘 모르는 이야기에 대해서는 꾸며서 이야기 하기 보다 모른다고 이야기해줘..

이렇게 프롬프트를 작성ㄹ하게 되면 근거없는 이야기를 줄일 수 있습니다..

물론!!! 이렇게 쓴다고 해서 100% 사실만을 이야기 하진 않지만...

최대한 거짓을 방지할 수 있기에 함께 씁니다.

확실한 정보가 없으면 나에게 반문하고 확인을 요청해줘...

이 프롬프트를 쓰는 이유는 AI 가 질문에 대한 답변을 지어내지 않고..

질문자와 상호작용하여 더욱더 정확한 답변을 이끌어 내기 위한 용도로 사용합니다...

역시나 "모르면 모르겠다...라고 이야기해줘.." 라는 내용도 함께 씁니다..

틀릴 가능성이 있으면 대답하지 말고 "확실하지 않음"이라고 알려줘...

이 프롬프트는 GPT가 자신없는 정보를 덜 이야기 하도록 쓰는 내용입니다...

자신이 없다면.. 내용은 전달하지만 "확실하지 않음"이라는 걸 포함해 답변하기 때문에..

그런 경우라면 제가 답변을 좀 더 걸러서 볼 수 있기 때문이에요~

하지만 주의하셔야 합니다..

GTP는 검색엔진이 아니고 지식DB 도 아니기 때문에 최신 정보나 정확한 사실 확인은 원칙적으로 불가합니다...

그래서 최신정보나 법률, 의학, 금융처럼 중요한 주제는..

내 스스로가 반드시 검증을 해야 하는 부분입니다..

챗GPT는 정말 잘 활용한다면 "스마트한 조언자" 일 수 있겠지만...

"절대적인 진리의 사전"은 아닙니다...

그래서 우리 스스로가 똑똑하게 활용하면서도 스스로 걸러내는 눈을 기르는게 더 중요한것 같아요...

그래서 AI에게 도움은 받지만..

최종 선택은 우리 스스로가 검증하고 한번 더 생각하고 사용하는것...

이게 진짜 스마트한 AI활용법이 아닐까 생각해봅니다...

오늘도 도움이 되셨기를 바래요~

읽어주셔서 감사합니다~

'🧠 생활꿀팁' 카테고리의 다른 글

| 소상공인 50만원 지원신청.. 이렇게 신청하세요.. 신청방법 총 정리~ (3) | 2025.07.21 |

|---|---|

| 2025년 소상공인 정책 소상공인 부담경감 크레딧 신청하세요~ (3) | 2025.07.21 |

| 서울대학교 캠퍼스 견학신청 이렇게 하세요~ (4) | 2025.07.16 |

| 초등학생 서울대학교 캠퍼스 견학 프로그램 신청하세요~ (2) | 2025.07.16 |

| 국가유산 방문자 여권 투어.. 여권 이렇게 신청하세요~ (6) | 2025.06.10 |